Les lois de non-conservation

Abstract

This article reviews some of the fundamental concepts which have emerged since the 1970s/80s, both in theoretical physics and mathematical logic, and evaluates the duality between geometry and causality which has risen from them. The first part relates to questions of invariance and the laws of conservation, concepts of theoretical physics which have been relatively well popularized in literature over the past few decades. The second part mentions questions of scale and in particular a possible and surprising link between Planck time physics and computing. The third part relates to the concepts of symmetry breaking and phase transition and their link to the contemporary theories of the network. The fourth part is entitled “nature of logic and logic of nature”, and outlines recent developments in mathematical logic, a field which is in full revival, thanks in particular to the impetus of the mathematician Jean-Yves Girard, who sees the sudden emergence of quantum phyics in terms of what was called the “laws of thought” in the 19th Century. There is a long list of topics in the texts concentrating on contemporary art and echoing the scientific ideas described in this article: the connection between total and local, between implicit and explicit, control, normativity, the observer, participation, relation, interaction… digital. However, the purpose here is not to extract aesthetic considerations from the articulation of these concepts which are fascinating in themselves. Even in the last paragraph where I rapidly present some of my artistic projects, I try to dissociate myself and take on the opposite point of view in relation to what was exposed before. If I touch on my artistic work, it's more to test, or even invalidate the concepts described previously, but in contexts so different that most of the time one cannot recognize them.

Texte intégral

Dans cet article je me suis donné tout d'abord comme tâche de brosser un panorama des concepts fondamentaux qui ont émergé à partir des années 1970/80, à la fois en physique théorique et en logique mathématique. Ces concepts portent en eux des changements de paradigmes qui sont issus des transformations de la pensée du XXème siècle, mais l'ampleur, la nouveauté et la rigueur qu'ils acquièrent par le travail de la Science, repoussent l'aventure humaine vers de nouveaux retranchements. Si la pensée a pu avoir l'intuition de ces concepts hors du champ de la Science, elle n'a pas encore pris la mesure du fait que la Science avait extirpé ces concepts hors du discours pour les rendre opératoires.

Le panorama, bien sûr non exhaustif, est cependant très rapide et dense, sans doute difficile à suivre pour le profane, mais au moins, l'unité entre les différents champs n'en sera que renforcée grâce à cet exercice de distant reading. De cette unité se dégage une dualité, on le verra, entre géométrie et causalité. La première partie concerne des concepts de la physique théorique qui sont relativement bien vulgarisés dans la littérature depuis quelques décennies. Ceux de la deuxième partie sont plus obscurs mais la fascination qu'ils exercent fait qu'ils ont aussi été décrits et popularisés maintes fois. On y évoque notamment un lien possible et surprenant entre la physique à l'échelle de Planck et l'informatique. La troisième partie concerne des champs plus récents et peut-être considérés comme moins « purs », mais d'un grand intérêt, en particulier dans leur lien avec le thème du réseau, du Web 2.0 plus précisément. La quatrième partie intitulée « nature de la logique et logique de la nature », concerne les développements récents de la logique mathématique, champ en plein renouveau sous l'impulsion notamment du mathématicien Jean-Yves Girard et qui voit l'irruption du quantique à l'intérieur de ce qu'on a pu appeler au XIXème siècle : « lois de la pensée ».

Pourquoi procéder à un tel passage en revue, qui condense un maximum de concepts abscons en un minimum de pages ? Au-delà de la performance de compression, c'est simplement qu'en tant qu'artiste, ces concepts m'accompagnent, bien que je ne cherche pas à les illustrer directement dans mon travail. Il s'agirait plutôt de les tester, de les invalider, mais dans des contextes si différents que la plupart du temps on ne les y reconnait pas.

La liste est longue des thèmes abordés dans les textes qui traitent d'art contemporain et qui font écho aux idées scientifiques décrites ci-après : l'articulation entre global et local, entre implicite et explicite, le contrôle, la normativité, l'observateur, la participation, la relation, l'interaction... le numérique... Je n'ai pas vraiment voulu extraire de considérations esthétiques de l'articulation de ces concepts. Ils sont fascinants en eux-même et n'ont besoin de rien d'autre. Même dans le dernier paragraphe où j'évoque mes derniers projets artistiques, je prends soin de me démarquer et de prendre plutôt le contre-pied de ce qui a été exposé auparavant.

Lois de conservation, symétries, invariances

A partir de Galilée, le concept d'invariance, de symétrie, commence à jouer un rôle en physique, rôle qui ne fera que s'accentuer pour arriver aujourd'hui à occuper une place si importante qu'on peut dire que la donnée d'une symétrie détermine la forme générale d'une théorie physique.

Choisissez par exemple l'invariance par translation dans l'espace, c'est-à-dire que vous supposez que l'espace est symétrique, invariant, par changement de référentiel galiléen (le principe de l'invariance galiléenne, dit précisément que les lois de la Physique sont identiques - on dit covariantes - dans tous les référentiels en translation uniforme les uns par rapport aux autres) et vous obtenez le célèbre principe d'inertie. La symétrie par translation implique la conservation de la vitesse (plus exactement de ce qu'on appelle quantité de mouvement). Vous pouvez également supposer la symétrie de l'espace par rotation et vous commencez à comprendre pourquoi une toupie tourne si facilement sur elle-même. Ensuite, si vous étendez ces notions d'invariances à l'espace-temps (transformations dites de Lorentz), vous obtenez immédiatement et sans hypothèse majeure supplémentaire la théorie de la Relativité Restreinte. Les translations et rotations de l'espace-temps font partie d'un groupe de symétrie plus vaste, celui de toutes les déformations de l'espace-temps qui préservent localement la notion de distance d'espace-temps (un peu comme si on mesurait un espace en partant d'une grille orthogonale et qu'on la déformait continument à loisir). Le résultat direct est la formulation de la théorie de la Relativité Générale. On voit que dans cette évolution chaque nouveau groupe de transformations contient, généralise le précédent, ce qui semble donner un cadre rationnel à l'évolution des concepts en physique, de la physique d'Aristote à la Relativité Générale, par la remise en question d'un absolu, par l'extension du principe d'invariance ou de relativité à une symétrie à chaque fois plus vaste. Plus récemment on a commencé à suspecter que la notion de distance d'espace-temps elle-même pourrait n'être qu'un effet secondaire résultant de l'existence d'un monde sous-jacent qui serait purement topologique, c'est à dire un monde où la notion de distance n'a plus le rôle prépondérant qu'elle semble avoir pour nous. Ce qui compte du point de vue topologique, c'est par exemple le nombre de trous dans un bretzel et non pas sa forme. Cependant ces Théories Topologiques des Champs (Théorie M ou Théories de Cordes) n'ont jamais été validées expérimentalement.

La question de l'invariance en physique est en tous cas devenue une véritable industrie en physique des particules. On ne compte plus les groupes de symétrie qui permettent de construire des théories toutes plus sophistiquées les unes que les autres. Pour la théorie des photons et des électrons c'est un groupe appelé U(1) (qui ressemble à des rotations sur un cercle, mais dans un espace qui n'est pas l'espace-temps). La théorie des quarks est basée sur un groupe plus complexe appelé SU(3) etc.

Le concept de symétrie propose donc de remplacer une approche causale, par une approche géométrique (c'est le terme souvent utilisé dans la littérature et que j'utiliserai par la suite, mais on pourrait discuter de son caractère approprié puisque l'émergence des Théories de Cordes suggère que la notion de métrique en physique est un sous-produit de celle de topologie, cf également la section suivante). On croyait auparavant que le mouvement était causé par une force, alors qu'il n'est qu'un effet de perspective, du à la géométrie de l'espace-temps. Il se trouve que cette question de la géométrie de l'espace, plus exactement la découverte par Gauss, Riemann et al. de géométries non-euclidiennes au XIXème siècle, va participer de manière décisive au déclenchement de ce que l'on a appelé la crise des fondements des mathématiques. Nous y reviendrons plus loin.

Point fondamental : toute symétrie est associée à une loi de conservation. Par exemple, l'invariance par translation dans le temps implique que l'énergie est conservée, l'invariance par translation dans l'espace implique que la quantité de mouvement est conservée, et l'invariance par rotation dans l'espace implique que le moment angulaire (cf. la toupie) est conservé. Dans le cadre de la Relativité, il s'agit de la conservation de la distance d'espace-temps etc. C'est en fait un théorème très général établi en 1918 par la mathématicienne Emmy Noether, qualifié par Einstein de « monument de la pensée mathématique ».

Le concept d'échelle

Si la symétrie joue un rôle crucial, elle ne permet pourtant pas de dire tout d'une théorie physique, dont le principe peut tenir par ailleurs dans une équation d'une ligne sur une feuille de papier. La formulation de la Relativité Générale est très économe en terme de signes, de même que celle du Modèle Standard en physique des particules, pourtant, on ne sait pas résoudre ces théories dans toutes les circonstances possibles.

Il y a bien sûr les problèmes de complexité : on sait par exemple depuis Poincaré à la fin du XIXème siècle que le comportement d'un système à trois corps est chaotique même dans le cas d'interactions Newtoniennes classiques. La théorie du chaos concerne des systèmes rigoureusement déterministes, mais qui présentent un phénomène fondamental d'instabilité, une « sensibilité aux conditions initiales », qui peut les rendre non prédictibles sur le long terme.

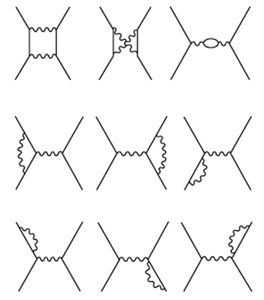

Mais en Théorie Quantique des Champs, c'est à dire en physique des particules, la situation est encore « pire ». Les physiciens se sont aperçus que leurs belles théories symétriques et élégantes, même si elles étaient prédictives dans certains cas, possédaient une grave maladie lorsqu'ils essayaient de les résoudre par des méthodes dites perturbatives : elles donnaient des résultats infinis qui les rendaient sinon inutilisables, du moins suspectes. Soit par exemple un électron dans le vide quantique. L'électrodynamique quantique (théorie des photons et des électrons) affirme que l'électron n'est en fait jamais seul, mais est entouré d'un nuage de photons virtuels. En permanence, l'électron émet et réabsorbe des photons et la distance que parcourt le photon entre son émission et sa réabsorption est d'autant plus courte que le photon est énergétique. Si l'on veut comprendre ce qui se passe pour l'électron, il faut additionner tous les effets dus aux photons. Le problème est alors que lorsque l'on tient compte des photons dont la distance émission / absorption est de plus en plus petite, l'effet devient de plus en plus grand jusqu'à devenir infini lorsque cette distance tend vers zéro. La conséquence est alors potentiellement catastrophique pour la théorie : cela veut dire que lorsque l'on va essayer de prédire le résultat d'une mesure expérimentale, on va trouver un résultat infini, ce qui n'a aucun sens.

Les Théories Topologiques des Champs dessinent la promesse d'une compréhension possible de ces problèmes de renormalisabilité, liés à ces infinis qui grèvent la Théorie Quantique des Champs, en particulier lorsque l'on veut la réunifier avec la Relativité Générale. Un des concepts les plus étonnants qui semble émerger est celui d'une possible distance minimale dans l'univers : en-deçà d'une certaine distance, l'échelle de Planck qui est de l'ordre de 1,6×10-33cm, la notion de distance elle-même disparaîtrait (et donc celle de forme) pour être remplacée par un concept d'invariance plus vaste, celui de topologie. Il faut parler ici au conditionnel, car comme je l'ai déjà dit, ces Théories Topologiques des Champs ne sont pas vérifiables expérimentalement pour l'instant. Dans ce contexte, les quantités infinies qui apparaissent lors de la quantification de la gravitation s'évanouiraient naturellement : ces infinis proviennent du fait que l'on doit prendre en compte tous les processus à toutes les échelles y compris vers l'infiniment petit, c'est-à-dire lorsque l'énergie tend vers l'infini. Si cet infiniment petit n'était qu'un fantasme, tout deviendrait calculable. Dans ce type de théories, en supposant qu'elles soient valides, la notion même d'unité disparait (adieu nos chers centimètres, secondes, degrés ou autres monnaies) : il suffit de poser l'échelle de Planck (désormais distance ultime infranchissable) égale à 1, la vitesse de la lumière égale à 1 également (puisqu'elle est la même dans tous les référentiels) et la constante de Planck (constante universelle qui mesure l'importance des fluctuations quantiques, à ne pas confondre avec l'échelle du même nom), égale à 1 elle aussi.Petit à petit, les physiciens se rendirent compte qu'il existe une petite classe de théories, dites renormalisables, pour lesquelles il est possible de se débarrasser des infinis, même lorsqu'on tient compte des interactions à courtes distances. C'est le cas de l'électrodynamique quantique qui permet de faire des prédictions finies, qui sont très bien vérifiées expérimentalement. Au contraire, la théorie de la gravitation, c'est-à-dire la Relativité Générale, fait partie des théories non renormalisables. Pour décrire l'interaction gravitationnelle, on postule l'existence de particules appelées gravitons qui véhiculent cette interaction. Si l'on essaie de décrire une particule entourée d'un nuage de gravitons, on trouve des quantités infinies si l'on permet à ceuxci d'interagir sur des distances aussi petites que l'on veut. Mais ces infinis engendrés par les fluctuations quantiques de l'espace-temps sont inéliminables. On peut ainsi très bien comprendre (ou avoir l'impression de comprendre) une théorie physique à très longue distance - c'est-à-dire aux basses énergies, selon le principe d'incertitude de la physique quantique - alors que celle-ci reste très mystérieuse à des énergies plus élevées... et inversement.

L'idée que l'on ne peut pas subdiviser la matière à l'infini se retrouve dans une conjecture en lien avec l'entropie des trous noirs, qui établit un pont possible entre la physique à l'échelle de Planck d'une part, et l'informatique d'autre part. Cette conjecture, appelée principe holographique, propose que toute l'information contenue dans un volume peut être décrite par une théorie qui vit sur la surface de ce volume. L'entropie, mesure du désordre, est ici mesurée en bits (un bit est considéré ici comme relié à l'échelle de Planck). L'entropie encode et mesure l'information relative aux états de la matière et de l'énergie qui occupent l'espace donné. L'existence d'une limite de densité d'entropie implique une limite supérieure à la densité d'information relative aux particules dans un volume donné, suggérant que la matière elle-même ne peut pas être subdivisée indéfiniment. Le principe holographique revient finalement à dire que les subdivisions doivent s'arrêter à un certain niveau et que l'ultime particule est un bit d'information (1 ou 0). L'univers serait en quelque sorte un gros ordinateur quantique.

Transitions de phase - invariance d'échelle - local vs global

Il existe des rapports profonds, subtils, complexes, entre d'une part les questions de symétrie, ou plus précisément la manière dont les groupes de symétrie s'imbriquent les uns dans les autres, d'autre part les questions d'infinis et de renormalisabilité, et enfin les questions d'échelles, ie. comment l'on passe de l'infiniment petit à l'infiniment grand, du local au global. Ces liens sont regroupés derrières les concepts de transitions de phases, de points critiques, d'invariance d'échelle et de brisure spontanée de symétrie. La théorie de la renormalisation est la tentative de décrire comment un système se comporte lorsque l'on change d'échelle. Il arrive qu'à certaines échelles, la corrélation entre constituants du milieu varie de manière brutale. On observe alors un phénomène de transition de phase, comme l'ébullition de l'eau par exemple. Ces échelles particulières sont appelées points critiques. Dans certaines des théories que l'on comprend suffisamment, on voit que le point critique est un point de brisure spontanée de symétrie où le système passe brusquement d’une phase plus symétrique à haute température à une phase moins symétrique à basse température. Dans la transition vers la phase moins symétrique, on observe par exemple que les constituants s'orientent spontanément et tous ensembles, de manière globale, selon une direction donnée, alors que dans la phase plus symétrique, à température plus élevée, chaque constituant semblait jouer son propre jeu et fluctuer indépendamment des autres.

Au voisinage du point critique, les longueurs de corrélation qui décrivent le comportement collectif des constituants deviennent très grandes et le système devient invariant d'échelle. On ne peut plus vraiment distinguer le local du global. Ce type de phénomène joue un rôle important dans la compréhension de l'imbrication des symétries dans les Théories Quantiques des Champs, évoquée plus haut, et bien sur dans tous les domaines liés à la physique statistique, en biologie, en économie, jusqu'aux récentes formulations de la théorie des graphes et de la théorie de l'information. À partir d'un certain seuil critique de complexité, de nouvelles propriétés peuvent apparaitre dans ces systèmes dont l'organisation est modifiée, elles sont dites propriétés émergentes.

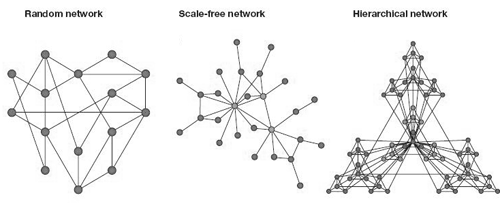

Un de ces domaines qui est particulièrement d'actualité en raison de son lien avec le Web 2.0, est celui de la théorie des graphes invariants d’échelle, développée dans les années 2000 par le mathématicien Albert-László Barabási et vulgarisée dans son ouvrage Linked: How Everything Is Connected to Everything Else and What It Means for Business, Science, and Everyday Life.{{BARABÁSI, Albert-László. Linked : How Everything Is Connected to Everything Else and What It Means for Business, Science, and Everyday Life . 2è Ed. : Plume Books, 2003. 304 p.}} La théorie des graphes invariants d'échelle doit beaucoup à la compréhension des phénomènes critiques évoqués ci-dessus, l'invariance d'échelle résultant du fait que ces graphes sont au voisinage d'un point critique. On utilise ces concepts lorsque l'on essaie de décrire par exemple comment une information va se mettre d'un seul coup à se propager très rapidement de manière virale sur un réseau. Ces graphes invariants d'échelle obéissent aux trois lois désormais bien connues :

- « small world », le concept de « petit monde » popularisé par le sociologue Stanley Milgram{{Travers, Jeffrey & Milgram, Stanley, 1969. « An Experimental Study of the Small World Problem. » Sociometry, Vol. 32, No. 4, pp. 425-443}}

- « strength of weak ties », « la force des liens faibles », découverte par Mark Granovetter{{GRANOVETTER, Mark. « The Strength of Weak Ties »; American Journal of Sociology, Vol. 78, No. 6., May 1973}}

- « rich get richer », règle de « l’attachement préférentiel », à savoir le fait que plus un noeud est connecté, plus il a de chance d’acquérir de nouvelles connections.

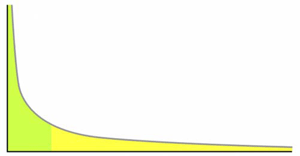

L’ironie de l’histoire veut que le réseau des réseaux ait été construit avec comme idéal le réseau démocratiquement distribué (random network), afin, comme on sait, de survivre à une attaque nucléaire. Or la découverte de Barabási montre que le Web, les réseaux sociaux, les réseaux sémantiques, certains réseaux économiques et bien d’autres, tendent à évoluer naturellement vers une configuration « aristocratique » invariante d'échelle, dans laquelle les noeuds du réseau sont fortement hiérarchisés. Cette découverte mathématique prend aujourd'hui une dimension idéologique et universelle, comme le Darwinisme en son temps. L’invariance d’échelle signifie que chaque noeud du réseau est un microcosme qui reflète la structure globale du réseau, ou macrocosme. Dans le domaine économique, cette théorie correspond à une extension des théories néo-classiques de la valeur, et à ce que l’on appelle la longue traîne{{ANDERSON, Chris. « The long tail », Wired, 2004 disponible à l'adresse wired.com/wired/archive/12.10/tail.html}} (long tail), paradigme du Web 2.0.

La distribution en loi de puissance de la longue traine, décrit par exemple le classement de la popularité des sites web. A gauche, la zone verte, fordiste, correspond à la situation dans laquelle un produit ou un message est proposé en masse, à l'identique, à un grand nombre de consommateurs. Cette zone de gauche prolongée jusqu'à la partie centrale illustre le principe des 80-20 de la loi de Pareto. A droite, la queue de la distribution illustre l'effet de longue traîne, postfordiste, redécouvert par le Web 2.0 : elle est constituée de l'ensemble des marchés de niche, chaque consommateur étant susceptible de recevoir l'objet qui conviendra à son désir particulier. Cet effet est typique d’une économie de flux dans laquelle les coûts de stockage deviennent faibles, en particulier dans le cadre des phénomènes de dématérialisation.

Nature de la logique et logique de la nature

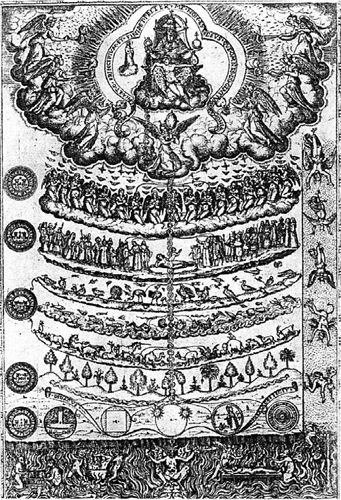

Le plus étonnant est finalement que cette structure de réseau invariant d'échelle, paradigme de notre hyper-modernité, présente de fortes ressemblances avec la forme qui a dominé l’histoire de la pensée de l’Antiquité jusqu’à la fin de la Renaissance : la Grande Chaîne de l’Être. On retrouve l'idée d'invariance d'échelle dans la symétrie entre macrocosmos et microcosmos, le Saint-Esprit circulant le long de la Grande Chaîne comme les flux d'information à travers le réseau.

Symétries et lois de conservation ont un statut fondamental qu'il faut replacer dans le débat conceptuel entre géométrie et causalité. D'un côté, donc, la géométrie, la symétrie ; de l'autre, la cause, la force, l'induction. C'est cette deuxième série de concepts, liés à la causalité, que la science remet progressivement en question, voire repousse hors de son champ, dans un mouvement millénaire qui continue aujourd'hui avec, dans le cadre de la logique mathématique, les récentes avancées de la Logique Linéaire et de la Géométrie de l'Interaction fondées par Jean-Yves Girard.{{Cette section se base principalement sur les références suivantes : * GIRARD, Jean-Yves. « Le point aveugle, Tomes 1 et 2 », Hermann, 2007. * JOINET, Jean-Baptiste. « Nature et logique de G. Gentzen à J-Y. Girard » disponible à l'adresse philo.univ-paris1.fr/Joinet/GentzenGirard.pdf.* JOINET, Jean-Baptiste. « Ouvrir la logique au monde » disponible à l'adresse philo.univ-paris1.fr/Joinet/OuvrirLogiqAuMonde.pdf.* MOSCA, Antonio. « Jean-Yves Girard, le logicien scélérat », Critique, Paris, 2005, vol. 61, no701, pp. 743-75.}} Dans la Géométrie de l'Interaction, en effet, une valeur de vérité comporte une composante en devenir et ne peut en aucune façon se ramener à une collection de futurs possibles, ce qui relègue l'induction (forme logicisée de la généralisation, incarnée dans le principe de récurrence) vers des contrées « essentialisantes », selon la terminologie de Girard, et offre à la question de la complexité algorithmique un contexte plus adéquat.

L'idée que le langage serait le constituant primitif de la pensée a émergé en philosophie avec Wittgenstein,{{Wittgenstein, Ludwig. « Tractatus logico-philosophicus », suivi de « Investigations philosophiques. » trad. P. Klossowski, Gallimard, 1961. 364 p.}} suivant Frege, Peirce et Russell. Pour comprendre comment ce « tournant langagier » (« linguistic turn ») puisse être qualifié par Girard d'idée géniale transformée en « machine à décerveler », revenons au débat entre géométrie et causalité. L'entreprise de Hilbert au début du XXè siècle, qui vise à faire des mathématiques une sphère formaliste autonome, est imprégné de l'idée de codage. Ébranlés par la découverte des géométries non-euclidiennes, les mathématiciens des années 1900 et Hilbert en particulier, s'attachèrent à axiomatiser la géométrie et à l'encoder dans l'arithmétique, avant de formuler le fameux programme qui aurait dû assurer les fondements des mathématiques en montrant la cohérence de l'arithmétique par des moyens finitaires, donc sûrs.

« Nous devons savoir. Nous saurons », déclare Hilbert en 1930, juste avant la découverte par Gödel de ses théorèmes d'incomplétude. Que fait Gödel ? il encode la méta-théorie de l'arithmétique dans l'arithmétique elle-même. La méta-théorie devient donc une sous-théorie de la théorie ! Puis il construit une proposition qui affirme sa propre indémontrabilité (du type « Je ne suis pas démontrable », utilisant l'argument diagonal, version formelle du paradoxe du menteur).

Enfin il montre que ni cette proposition, ni sa négation, ne sont démontrables par des moyens finitaires. Dans n'importe quelle théorie récursivement axiomatisable, cohérente et capable de « formaliser l'arithmétique », on peut construire un énoncé arithmétique qui est vrai mais qui ne peut être ni prouvé ni réfuté dans cette théorie. De tels énoncés sont dits indécidables dans cette théorie, cohérente mais incomplète. De plus, il existe un énoncé exprimant la cohérence de la théorie qui ne peut pas être démontré dans la théorie elle-même.

La démonstration de Gödel en 1931, si elle ruine le programme de Hilbert, pousse à l'extrême les outils formalistes. En particulier, l'utilisation qu'il fait du codage peut-être considérée comme le point d'origine de ce qui deviendra ensuite l'informatique avec Turing, de la théorie de l'information de Shannon et enfin du Web tel que nous le connaissons aujourd'hui. Il s'agit ni plus ni moins que de la toute première numérisation d'un langage.

Malgré la faillite salutaire du programme de Hilbert, la logique s'est ensuite enferrée dans la voie qu'elle avait pris lors du tournant linguistique par son obsession de l'axiomatisation, du codage et de la causalité, et l'établissement de la trinité syntaxe, sémantique, méta : un langage sera un alphabet fini, la syntaxe permettra de construire énoncés et démonstrations, la sémantique interprètera le langage dans un modèle, le tout formalisé dans un métalangage médiateur entre syntaxe et sémantique.

Pourtant Wittgenstein avait une toute autre vision en tête comme le prouvent ses remarques sur le jeu d'échec, lorsqu'il propose de remplacer les pièces du jeu par les règles elles-mêmes : cela ne produit pas un méta-jeu mais un nouveau jeu. Pourtant la Mécanique Quantique et la Relativité Générale avaient contribué à jeter le doute. Une partition absolue du monde en fini/infini ne tient pas du point de vue de la Relativité puisqu'un observateur intérieur à une sphère de Riemann la considèrera comme infinie alors qu'elle sera finie pour un observateur extérieur. Bien que les idées de relativité et d'indéterminisme aient largement envahi le sens commun et la philosophie, il faudra attendre plus de cinquante ans pour comprendre qu'il en est de même en logique des oppositions vrai/faux, prouvable/non-prouvable, qui dans une vision essentialiste partageraient en deux un univers. Mises à mal par Gödel, ces dichotomies se révèleront elles aussi finalement dépendantes du choix d'un système de référence, d'un point de vue, d'une mesure, dans le cadre de ce que l'on appelle aujourd'hui le « tournant géométrique » opéré par la Géométrie de l'Interaction.{{JOINET, Jean-Baptiste. Tronçon, Samuel. « Ouvrir la logique au monde. Philosophie et mathématique de l’interaction ». Hermann, 2008.}}

Alors que la logique était supposée précéder la mathématique du point de vue des fondements, le tournant géométrique fait reposer la logique, non plus sur le langage, mais sur la géométrie, donc sur la mathématique. Depuis l’Antiquité grecque, une démonstration se construisait à partir d'axiomes et de règles de déduction, sans aucun lien avec la notion de calcul, encore moins d'algorithme. Dans les années 70, la correspondance de Curry-Howard remplace le paradigme des preuves-comme-discours par celui des preuves-comme-programmes (dans un premier temps dans le cadre de la logique intuitionniste). La notion de démonstration se transforme et la prééminence du raisonnement sur le calcul s'efface. Une preuve de A => B s'interprète désormais comme une fonction de A vers B. Héritière de l'esprit du lambda-calcul d'Alonzo Church, qui dans les années 30 avait proposé une alternative à la théorie des ensembles, alternative dans laquelle « tout est fonction », cette interprétation contient en germe une révolution dans la logique qui va devenir une théorie des fondements du calcul. La découverte de l'isomorphisme de Curry-Howard replace le raisonnement en tant que processus dynamique au coeur de la logique : une preuve, c'est un programme informatique, une fonction ; un théorème c'est une spécification (un type) ; une preuve de A =>B, c'est un programme qui prend une preuve de A en entrée et rend une preuve de B en sortie. Ce changement de paradigme a lieu dans le cadre du développement de la théorie des catégories qui met l'accent sur la dimension fonctionnelle, sur les relations entre objets, les isomorphismes (identités quant-à la forme ; la donnée des relations entre objets informe sur la structure des objets eux-mêmes).

Revenons un instant en arrière. Dans ses travaux visionnaires, Gerhard Gentzen avait introduit la déduction naturelle puis le calcul des séquents et démontré son théorème fondamental (Hauptsatz) de l'élimination des coupures publié en 1934. Le théorème fondamental affirme que toute démonstration peut se ramener à une forme dite normale, dont la propriété essentielle est qu'on n'y introduit aucun concept qui ne soit pas contenu dans son résultat final et qui, par conséquent, ne doive pas nécessairement être utilisé pour obtenir ce résultat. La coupure est ce qui rend possible un raisonnement mathématique. « Je suis un homme », « homme => mortel ». Donc : « je suis mortel ». Le terme moyen (le lemme), ici « homme », a disparu : il a été coupé.

Exercice : à partir de l'assertion « Je regarde la Star Academy », reconstruisez un raisonnement qui passe par « homme », « mortel », « argent » et « caniche ». Dans le voyage à travers le monde de la pensée, plus il y a d'escales, plus on découvre... On sait aujourd'hui dans le cadre de Curry-Howard, que l'exécution d'un programme informatique est isomorphe à l'opération d'élimination des coupures en théorie de la démonstration, c'est-à-dire à la transformation de l'implicite en explicite, également appelé normalisation ou analytisation des preuves.

En 1986, Jean-Yves Girard publie la Logique Linéaire. Viendront ensuite la Ludique et la Géométrie de l'Interaction. Pour passer du monde des formules au monde des preuves comme processus, puis à la question de l'interaction entre les processus, il déconstruit la distinction syntaxe / sémantique en se plaçant du point de vue des processus dynamiques de recherche de preuves (qui peuvent aboutir ou ne pas aboutir, s'éterniser). La question statique de la véridicité d'un énoncé, des « lois de l'être vrai » de Frege, est remplacée par l'étude de la façon avec laquelle le discours agit sur lui-même, à l’intérieur de lui-même ; comment le langage interagit avec le langage (ce qui est autre chose que le méta-langage). La négation linéaire (non-A peutêtre vu comme l'espace des interdits de A, et inversement) devient dualité, échange de point de vue entre joueurs, entre questions et réponses. Il n'est pas besoin d'un au-delà essentialiste, extérieur aux preuves, dans lequel la division vrai/faux serait transparente. Au contraire, il faut enrichir, élargir le monde des démonstrations en un espace plus vaste où les réseaux de preuves interagissent entre eux de manière non domestiquée, des processus qui peuvent être infinitaires, indociles, rebelles, espace dans lequel la régulation, le contrôle sont plus souples, un espace où P et non-P pourraient être équivalents. Dans cet élargissement de l'espace des preuves, toute tentative de preuve devient acceptable en tant que dessein. Les formules apparaissent en tant que lieux, loci, et leur égalité se réduit à l'occupation d'un même locus. L'interprétation de la formule est donnée par son comportement, sa manière d'interagir avec les autres desseins. Les tentatives de preuves interagissent avec les tentatives de contre-preuves et une formule est prouvée lorsque l'une des deux tentatives converge et gagne. Mais les desseins perdants, qui selon Girard sont bien plus intéressants que ceux qui gagnent toujours, sont « les habitants réels de l'univers logique ».

Ce n'est que dans un temps second qu'une logique peut émerger dans le choix d'un point de vue, non pas par une limitation externe de la dynamique de socialisation des preuves et l'imposition de règles, mais de manière immanente, comme le produit d'une « auto-discipline de l’interaction » (toute ressemblance avec des phénomènes sociaux contemporains dits postmodernes est bien sûr tout sauf fortuite). La logique devient logique de sa propre procéduralité, Champ et hors-champ deviennent homogènes. Le typage émerge de propriétés de la dynamique, de même que la dénotation apparaît en fin de compte comme ce qui reste préservé, invariant, par transformation du sens. On retrouve ici, dans cette géométrisation de la pensée, les questions d'invariance et de symétrie découvertes par la physique au début du XXème siècle et évoquées plus haut.

Cette naturalisation des lois logiques a un prix, c'est le cas de le dire. L'implication linéaire, qui vit désormais dans le monde des morphismes qui se composent entre eux, nécessite de se débarrasser du caractère éternel des vérités logiques (caractère imparfait au sens de la grammaire). Si j'ai A, je n'ai plus automatiquement A et A. Il faut remettre au pot. De même qu'en informatique les ressources mémoire sont limitées, la Logique Linéaire oblige à respecter l'environnement et décrit les objets logiques comme des marchandises, des ressources, que l'on ne peut ni gaspiller, ni dupliquer sans coût (techniquement, on laisse de côté les règles de contraction et d'affaiblissement). Le parfait, c'est ce qui vit dans l'instant et qui ne s'éternise pas. Ce n'est que lorsque l'on va prendre en compte des interactions d'ordre supérieur non linéaires, que la question de l'infini va resurgir, dans l'idée d'exponentielle et de pérennité de la pérennité. D'où les sous-titres des deux tomes du Point Aveugle de Girard : Tome I, Vers la perfection et Tome II, Vers l'imperfection.

La Géométrie de l'Interaction qui s'éloigne du paradigme des catégories et dont l'ambition est de trouver les fondements mathématiques de la complexité algorithmique, débouche finalement sur une irruption du quantique dans la logique et la reconnaissance d'une intrication entre sujet et objet. Pour la première fois, après les tentatives de John Von Neumann, la nature de la logique semble pouvoir dialoguer avec la logique de la nature. Malgré les progrès accomplis, toutes deux continuent à souffrir du même mal, pour l'instant incurable : celui de l'infini.

Les lois de non-conservation

Un petit jeu récréatif pour finir. Si nous interprétions de manière sauvage le principe d'incertitude de la mécanique quantique pour essayer d'en déduire une loi qui serait valable dans le domaine de l'esthétique, nous pourrions dire par exemple qu'il existe un principe analogue entre observabilité et usage (au lieu de position et quantité de mouvement). En effet, après la déperdition de l'aura de l'objet due à la reproductibilité technique, le Pop d'une part, Fluxus, de l'autre, se sont emparés de la question pour tracer des voies différentes. Reprenant le concept de ready-made, le Pop extrait un objet banal des processus de production/consommation et le réinsère à l'identique (en le dupliquant) dans un contexte différent - celui de la galerie - afin que son aura soit restaurée, le faisant passer au stade de « marchandise absolue ».{{BAUDRILLARD, Jean. « De la marchandise absolue». Artstudio Spécial Andy Warhol. 1988, n°8, p. 6-12.}} C'est presque une opération logique élémentaire, linguistique plutôt, comme une citation. L'objet est comme mis entre guillemets. Fluxus, puis plus tard l'esthétique relationnelle, critiqueront cette position : si l'aura de l'objet a effectivement été transfigurée, l'usage de l'objet a été perdu au profit de son observabilité. Il faut donc pouvoir s'asseoir à nouveau sur les chaises et partager sa soupe avec les visiteurs. L'objet est alors restitué à son usage, aux processus de consommation. Mais dès lors qu'en est-il de l'observabilité ? Elle est perdue bien sûr puisque le spectateur devient acteur de l'oeuvre qui elle, devient action, performance, et il ne peut donc plus en rendre compte comme il convient. On en déduit une relation d'incertitude entre observabilité et usage, étrangement liée à la transition de l'objet vers la relation, les processus, les flux, qui s'est produite dans les années 1960/70.{{Cf par ex. RIFKIN, Jeremy, « The Age of Access », Penguin, 2000}}

Nous pouvons d'ailleurs continuer le jeu : nous avons d'abord perdu l'observabilité (l'aura), puis nous l'avons retrouvée dans le Pop en perdant l'usage, puis retrouvé l'usage grâce à Fluxus et reperdu l'observabilité... maintenant est-il encore possible de retrouver l'observabilité (et reperdre l'usage) ? Oui bien sûr : c'est l'exemple du net.art. Le langage tel qu'il se cristallise désormais sur le Web, peut être vu comme le codage de l'ensemble des relations humaines et cette structure panoptique utilitariste fait partie d'un dispositif de post-contrôle et de surveillance globale. Voilà l'observabilité retrouvée grâce à Big Brother Google ; la galerie s'est simplement étendue à l'échelle de la globalisation. Dans le « Google Adwords Happening »,{{BRUNO, Christophe. « Le Google Adwords Happening », 2001, disponible à l'adresse iterature.com/adwords}} performance globale sur le « capitalisme sémantique » dans lequel chaque mot de chaque langue a un prix, j'ai été censuré par le robot de surveillance non pas parce que ma parole était scandaleuse ou porteuse d'un sens trop prégnant, mais parce que je n'avais rien à dire : le taux de clics trop bas sur mes « poèmes » mettait en péril la dynamique économique globale du marché du langage, autrefois zone sacrée inviolable. Cette déchéance de l'aura du langage, taylorisation du discours, n'est rien d'autre que la déchéance de l'aura du relationnel. Bref, la perte de l'usage de la parole. Et voilà pour l'usage : perdu à nouveau !

Tout cela est peut-être très intéressant. Le principe d'incertitude séduit car il semble remettre en question nos modes de pensée, nous sommes dans l'impensable. Duchamp était fasciné par la quatrième dimension, les dadaïstes puis les surréalistes ont vénéré Raymond Roussel et l'idée de mécanisation du langage, et aujourd'hui on peut comprendre l'attrait quasi-mystique de notre imaginaire pour les concepts scientifiques contemporains : relations d'incertitude, relativité de l'observateur, théorie des catégories, algèbres de Von Neumann et autres beautés formelles.

La Géométrie de l'Interaction – peut-être non sans une certaine satisfaction - dévoile l'absence du Père de la Loi et se moque des gesticulations de qui viendrait usurper son trône imaginaire. Mais, c'est là le drame de l'aventure humaine, un tel dévoilement n'est pas neutre, puisqu'en effet il laisse la place vacante à n'importe quel gnome inconsistant. Ce non-lieu, ce trône vacant, ce locus des loci, s'il n'a pas de place dans le monde logique d'où l'éther et autre « méta » ont été expulsés, quel est son statut ?Mais comment interpréter la convergence entre nature de la logique et logique de la nature ? La dimension roussellienne de cette convergence (si ce n'est que Roussel était un moderne, alors que la Logique Linéaire vient après la modernité) n'indique-t'elle pas une déperdition du champ symbolique sans précédent ? Si la logique elle-même, loi de la pensée, révèle « l'impossibilité d'une élimination du numéraire »,{{MOSCA, Antonio. « Jean-Yves Girard, le logicien scélérat », Critique, Paris, 2005, vol. 61, no701, pp. 743-75}} si A n'implique plus désormais A et A, cela ne sonne-t'il pas comme un changement radical des stratégies de conquêtes telles que nous les avons connues jusqu'à présent, conquête de l'espace du savoir pour la Science, de l'espace de la jouissance pour le Capitalisme ? Une fois le territoire profané, sans doute restera-t'il toujours une échappatoire pour le symbolique, mais il devra peut-être se faufiler entre ses deux maîtres, avant qu'ils ne scellent leur alliance.

Le débat entre géométrie - empire des lois de conservation - et causalité, que Jean-Yves Girard relie à l'interaction entre existence et essence, fait écho à celui qui a lieu dans l'histoire de la pensée. La post-modernité et la chute des idéaux, mais aussi le meurtre du père, l'oedipe, sont, en tant que concepts, les avatars, les duaux de ces tsunamis qui se produisent dans la découverte scientifique. La cause, expulsée dans le hors champ de la science, possède son pendant, son dual : l'idéal, dont l'aura scintille de la place qu'aurait occupé l'objet perdu. Ce horschamp de la science, dont les frontières sont sans cesse repoussées, dont la consistance semble s'évanouir face à la rigueur et l'ampleur conceptuelle de l'avancée mathématique, n'est pas autre chose que le champ de la perte irréductible, celui de la non-conservation.

Mon projet « Non-Conservation Laws »,{{Mon projet « Non-Conservation Laws» a été lancé à Madrid en avril 2009, aux Rencontres Internationales Paris-Berlin-Madrid pour le nouveau cinéma et l'art contemporain, disponible à l'adresse cosmolalia.com/non-conservation-laws}} par son titre même - à double sens, vise le coeur même de l'intersection des points aveugles du discours de la science et des processus capitalistiques. C'est un projet artistique et curatorial qui va évoluer au cours des prochaines années. Il s'intéresse pour l'instant à la vie des oeuvres d'art après leur production et leur entrée dans le circuit de la consommation : leur espérance de vie, leurs pannes, leur dégradation... Il s'agit de ne pas se détourner des questions d'esthétique quantitative (aesthetics by numbers) pour en éprouver les limites mêmes, questions de temporalité, pérennité, émergence et déchéance à l'intérieur des processus de production-distribution-consommation du capitalisme de réseau, dans le contexte de la globalisation et sur le temps long.

Je terminerai avec la citation de Robert Musil qui introduit le livre du critique littéraire Franco Moretti, Graphes, Cartes et Arbres{{MORETTI, Franco. « Graphes, cartes et arbres. Modèles abstraits pour une autre histoire de la littérature », Les Prairies ordinaires, Collection penser/croiser, 2008.}} : « Un homme qui cherche la vérité se fait savant ; un homme qui veut laisser sa subjectivité s'épanouir devient peut-être écrivain. Mais que doit faire un homme qui cherche quelque chose situé entre les deux ? » Robert Musil, L'Homme sans qualités.

Octobre 2009

Remerciements

Un grand merci à Antonio Mosca pour sa relecture et ses remarques sur la partie « nature de la logique et logique de la nature », ainsi qu'à Daniele Balit, Etienne Cliquet, Emmanuel Melmoux et Florence Pélissier.